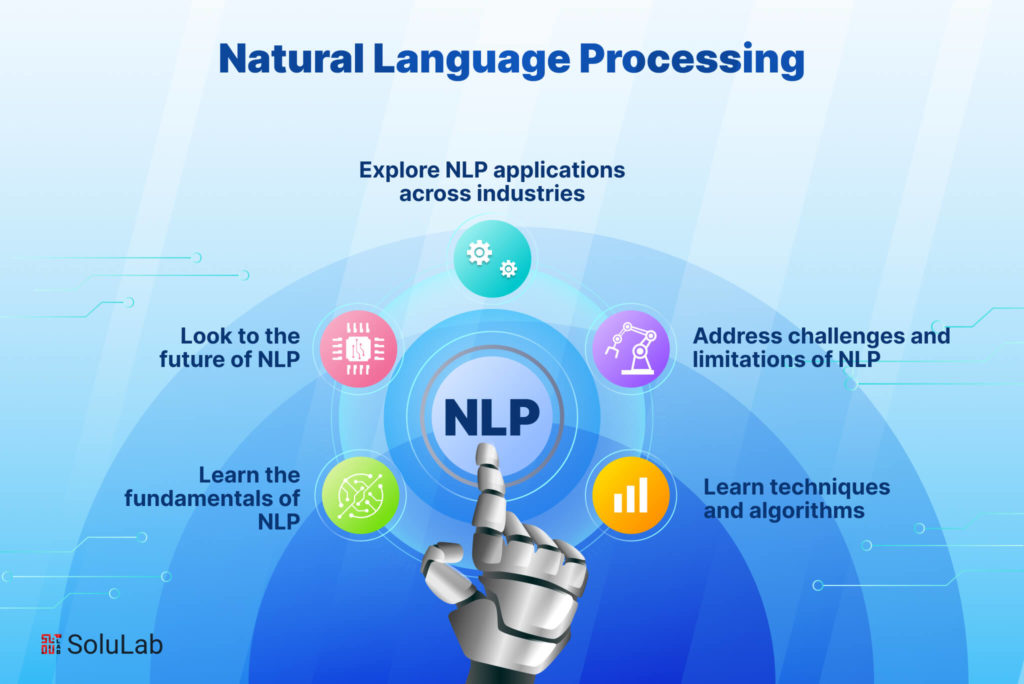

Wprowadzenie: Ewoluujący krajobraz rozwoju NLP

W zeszłym roku nastąpił niezwykły postęp w technologii NLP — od bardziej wydajnych podejść do precyzyjnego dostrajania po możliwości multimodalne, które łączą tekst z innymi typami danych. Wydajność środowiska wykonawczego stała się coraz ważniejsza, ponieważ więcej obciążeń NLP przenosi się na urządzenia brzegowe i sprzęt konsumencki. Tymczasem specjalistyczne możliwości domenowe rozszerzyły się, aby obsługiwać branże od opieki zdrowotnej po usługi prawne z niespotykaną dokładnością.

Bez względu na to, czy tworzysz agenta konwersacyjnego, analizujesz opinie klientów, wydobywasz spostrzeżenia z dokumentów czy tworzysz narzędzia do generowania treści, wybór odpowiedniej biblioteki NLP może znacząco wpłynąć na sukces Twojego projektu. W tym przewodniku omówiono siedem najbardziej wpływowych bibliotek NLP w 2025 roku, porównując ich mocne strony, ograniczenia i idealne przypadki użycia, aby pomóc Ci podjąć świadomą decyzję dotyczącą Twojego kolejnego projektu programistycznego.

1. Hugging Face Transformers 6.0: Kompleksowy ekosystem

Kluczowe funkcje i ulepszenia

Najnowsza wersja wprowadza kilka przełomowych funkcji:

Wydajna struktura dostrajania: Nowy moduł EFT znacznie zmniejsza wymagania obliczeniowe dotyczące dostosowywania modeli podstawowych do określonych zadań. Modele, które wcześniej wymagały wielu procesorów GPU do dostrajania, można teraz dostosować na sprzęcie konsumenckim przy minimalnych kompromisach w zakresie wydajności.

Multimodalne potoki: Transformers oferuje teraz usprawnione potoki do tworzenia aplikacji, które płynnie łączą analizę tekstu z obrazem, dźwiękiem, a nawet zrozumieniem wideo — idealne do tworzenia aplikacji bardziej świadomych kontekstu.

Narzędzia wdrażania klasy korporacyjnej: nowy zestaw narzędzi wdrażania upraszcza przenoszenie modeli z badań do produkcji dzięki automatycznej optymalizacji dla różnych celów sprzętowych, od klastrów serwerów po urządzenia mobilne.

Pakiety specjalizacji domeny: wstępnie skonfigurowane ustawienia i modele dla określonych branż, takich jak opieka zdrowotna, prawo i finanse, pozwalają deweloperom zacząć od zoptymalizowanych pod kątem domeny fundamentów, a nie ogólnych modeli.

Dlaczego deweloperzy to uwielbiają

Transformers nadal dominuje, ponieważ zapewnia wyjątkową równowagę między dostępnością a najnowocześniejszymi możliwościami. Dobrze udokumentowany interfejs API ułatwia nowicjuszom wdrażanie zaawansowanych funkcji NLP, a rozbudowane opcje dostosowywania zaspokajają potrzeby doświadczonych inżynierów ML.

Żywa społeczność otaczająca Hugging Face oznacza również, że rozwiązania typowych problemów są zwykle oddalone o wyszukiwanie na forum, co znacznie skraca czas rozwoju. Dzięki ponad 75 000 wstępnie wyszkolonych modeli dostępnych obecnie w Model Hub deweloperzy często mogą znaleźć specjalistyczne modele, które ściśle odpowiadają wymaganiom ich przypadków użycia, bez konieczności zaczynania od zera.

Idealne przypadki użycia

Hugging Face Transformers 6.0 sprawdza się w:

Projektach badawczych wymagających szybkich eksperymentów z różnymi architekturami modeli

Aplikacjach produkcyjnych wymagających najnowocześniejszego rozumienia języka

Zespółach chcących wykorzystać wiedzę i zasoby społeczności

Projektach wymagających specjalistycznej wiedzy domenowej (opieka zdrowotna, prawo, finanse)

Aplikacjach wymagających możliwości multimodalnych

Rozważania

Chociaż Transformers pozostaje najbardziej wszechstronną opcją, nie zawsze jest to najbardziej wydajny pod względem zasobów wybór do wdrożenia. Niektórzy programiści zgłaszają, że uogólniona architektura wprowadza narzut, którego unikają specjalistyczne biblioteki. Ponadto szybko ewoluująca baza kodu oznacza sporadyczne zmiany powodujące przerwanie pracy między głównymi wersjami.

2. SpaCy 4.0: wydajność gotowa do produkcji

Kluczowe funkcje i ulepszenia

SpaCy 4.0 wprowadza znaczące ulepszenia:

Integracja transformatorów: Zaktualizowane komponenty potoku transformatorów działają teraz natywnie z najnowszymi modelami, zachowując jednocześnie wydajną architekturę przetwarzania SpaCy.

Ulepszone przetwarzanie wieloprocesorowe: Nowe możliwości przetwarzania równoległego zapewniają niemal liniowe skalowanie zadań przetwarzania dokumentów, dzięki czemu SpaCy nadaje się do przetwarzania wsadowego ogromnych zbiorów tekstu.

Rozszerzone przewidywanie strukturalne: Oprócz rozpoznawania nazwanych jednostek i analizy zależności, SpaCy oferuje teraz ulepszone wsparcie dla niestandardowych zadań przewidywania strukturalnego poprzez bardziej elastyczne ramy adnotacji i szkolenia.

Wymagania Leaner Runtime: Pomimo zwiększonych możliwości, podstawowe potoki przetwarzania mogą teraz działać przy znacznie zmniejszonym wykorzystaniu pamięci — co ma kluczowe znaczenie dla wdrażania w środowiskach o ograniczonych zasobach.

Ulepszony silnik reguł: System dopasowywania wzorców został całkowicie przebudowany, oferując bardziej wydajne wyrażenia przy jednoczesnym zwiększeniu szybkości dopasowywania nawet o 300%.

Dlaczego wybierają go programiści

SpaCy nadal jest preferowanym wyborem dla systemów produkcyjnych, ponieważ zapewnia wydajność na poziomie przemysłowym z przyjaznym dla programistów interfejsem API. Przemyślana architektura zorientowana obiektowo ułatwia integrację z większymi aplikacjami przy jednoczesnym zachowaniu spójnej wydajności.

Nowe ramy „SpaCy Projects” uprościły również pakowanie i wdrażanie kompleksowych potoków przetwarzania języka naturalnego, umożliwiając zespołom standaryzację przepływów pracy programistycznej od eksperymentów do produkcji.

Idealne przypadki użycia

SpaCy 4.0 jest idealny dla:

Systemów przetwarzania tekstu o wysokiej przepustowości

Środowisk produkcyjnych, w których niezawodność i przewidywalność są kluczowe

Aplikacji wymagających przemysłowego rozpoznawania nazwanych jednostek i ekstrakcji relacji

Projektów z ograniczeniami wdrożenia (pamięć, moc obliczeniowa)

Zespołów, które potrzebują zarówno klasycznych możliwości przetwarzania języka naturalnego, jak i nowoczesnych podejść neuronowych

Rozważania

Chociaż SpaCy poczyniło duże postępy w zakresie włączania modeli transformatorów, nadal nie oferuje takiego samego zakresu najnowocześniejszych wdrożeń badawczych, jak Hugging Face. Ponadto niektórzy programiści uważają, że jego oparta na opiniach architektura jest mniej elastyczna w przypadku wysoce dostosowanych aplikacji badawczych.

3. Cohere SDK: inteligencja językowa oparta na API

Kluczowe funkcje i ulepszenia

Platforma Cohere oferuje kilka atrakcyjnych możliwości:

Modele Command i Command-R: Te modele doskonale radzą sobie z przestrzeganiem określonych instrukcji i rozumieniem niuansów żądań, co czyni je idealnymi do tworzenia narzędzi, które precyzyjnie odpowiadają na zapytania użytkowników.

Modele osadzania: Najnowszej generacji modele osadzania tworzą niezwykle dokładne reprezentacje semantyczne, znacznie przewyższając poprzednie podejścia w zadaniach pobierania i klasyfikacji.

Dostosowywanie przedsiębiorstwa: Dla organizacji o szczególnych potrzebach Cohere oferuje teraz opcje dostosowywania, które dostosowują ich podstawowe modele do wyspecjalizowanych domen bez konieczności stosowania ogromnych zestawów danych szkoleniowych.

Obsługa wielu języków: Solidne możliwości w ponad 100 językach umożliwiają globalne aplikacje bez konieczności stosowania oddzielnych modeli dla każdego języka.

Odpowiedzialne kontrole AI: wbudowane filtry bezpieczeństwa i wykrywanie stronniczości pomagają programistom tworzyć systemy spełniające coraz ważniejsze standardy etyczne.

Dlaczego programiści to wybierają

Cohere SDK zyskał popularność przede wszystkim dlatego, że radykalnie obniża barierę wdrażania zaawansowanych możliwości NLP. Programiści bez doświadczenia w uczeniu maszynowym mogą dodać zaawansowane rozumienie języka do aplikacji przy użyciu minimalnej ilości kodu, jednocześnie zachowując szczegółową kontrolę nad zachowaniem modelu w razie potrzeby.

Podejście API-first oznacza również, że zespoły nie muszą martwić się o zarządzanie infrastrukturą ani nadążać za najnowszymi osiągnięciami badawczymi — Cohere zajmuje się tymi aspektami, pozwalając programistom skupić się na logice aplikacji.

Idealne przypadki użycia

Cohere SDK doskonale sprawdza się w następujących przypadkach:

Startupy i zespoły bez dedykowanej infrastruktury ML

Aplikacje, które muszą szybko skalować się bez zarządzania wdrażaniem modelu

Projekty wymagające niezawodności i wsparcia klasy korporacyjnej

Aplikacje wielojęzyczne obsługujące rynki globalne

Przypadki użycia, w których odpowiedzialne praktyki AI są priorytetem

Rozważania

Głównym kompromisem w przypadku Cohere jest to, że programiści polegają na usłudze innej firmy, zamiast uruchamiać modele we własnej infrastrukturze. Tworzy to potencjalne obawy dotyczące prywatności danych, dostępności usług i długoterminowej stabilności cen. Niektórzy programiści zauważają również, że podejście oparte na interfejsie API, choć wygodne, czasami ogranicza elastyczność w porównaniu z bezpośrednim dostępem do wewnętrznych elementów modelu.

4. PyTorch NLP (torchtext 3.0): Wybór badacza

Kluczowe funkcje i ulepszenia

Najnowsza wersja wprowadza kilka znaczących ulepszeń:

Natywne wsparcie dla architektur transformatorów: pierwszorzędne implementacje mechanizmów uwagi i bloków transformatorów ułatwiają implementację niestandardowych architektur.

Zoptymalizowane potoki przetwarzania danych: nowe wektoryzowane operacje przetwarzania tekstu wykorzystują nowoczesne procesory CPU i GPU bardziej efektywnie, znacznie przyspieszając kroki wstępnego przetwarzania.

Ulepszona struktura Transfer Learning: udoskonalony interfejs API ułatwia dostosowywanie wstępnie wyszkolonych modeli do nowych zadań, zachowując jednocześnie precyzyjną kontrolę nad procesem szkolenia.

Narzędzia kwantyzacji i przycinania: wbudowane możliwości kompresji modelu umożliwiają badaczom zmniejszenie rozmiaru modelu i czasu wnioskowania bez nadmiernego pogorszenia wydajności.

Ulepszone przetwarzanie wsadowe: Inteligentniejsze strategie przetwarzania wsadowego dla sekwencji o zmiennej długości skutkują bardziej efektywnym wykorzystaniem GPU podczas treningu.

Dlaczego wybierają je badacze i deweloperzy

PyTorch NLP pozostaje preferowanym wyborem dla badań i specjalistycznych aplikacji, ponieważ oferuje maksymalną elastyczność bez poświęcania użyteczności. Imperatywny styl programowania jest zgodny z tym, jak myśli większość deweloperów, ułatwiając debugowanie modeli i eksperymentowanie z nowymi podejściami.

Bezproblemowa integracja z szerszym ekosystemem PyTorch oznacza również, że postępy w ogólnym głębokim uczeniu się (takie jak techniki optymalizacji lub metody szkolenia) są natychmiast stosowane w zadaniach NLP.

Idealne przypadki użycia

PyTorch NLP najlepiej nadaje się do:

Projektów badawczych eksplorujących nowe architektury lub podejścia do szkolenia

Aplikacji wymagających dostosowanego zachowania modelu, niedostępnego w bibliotekach wyższego poziomu

Kontekstów edukacyjnych, w których ważne jest zrozumienie wewnętrznych mechanizmów modelu

Projektów, w których konieczna jest integracja z komputerowym widzeniem lub innymi metodami

Sytuacji wymagających maksymalnej kontroli nad procesem szkolenia

Rozważania

Elastyczność PyTorch NLP wiąże się z trudniejszą nauką i większą odpowiedzialnością za wdrożenie. Deweloperzy muszą podejmować więcej decyzji architektonicznych i implementować więcej komponentów od podstaw w porównaniu z bibliotekami wyższego poziomu. Ponadto niektóre funkcje optymalizacji produkcji wymagają dodatkowej pracy, aby je prawidłowo wdrożyć.

5. JAX NLP (FLAX/Prax): wydajność na dużą skalę

Meta Description: Discover the most powerful and versatile natural language processing libraries of 2025 that are revolutionizing how developers build intelligent text applications.

Introduction: The Evolving Landscape of NLP Development

Natural Language Processing (NLP) continues to transform how we interact with technology in 2025. As the demand for sophisticated language understanding capabilities grows across industries, developers need powerful, efficient, and accessible tools to build applications that can genuinely understand and generate human language.

The past year has seen remarkable advancements in NLP technology—from more efficient fine-tuning approaches to multimodal capabilities that bridge text with other data types. Runtime efficiency has become increasingly important as more NLP workloads move to edge devices and consumer hardware. Meanwhile, specialized domain capabilities have expanded to serve industries from healthcare to legal services with unprecedented accuracy.

Whether you're building a conversational agent, analyzing customer feedback, extracting insights from documents, or creating content generation tools, choosing the right NLP library can dramatically impact your project's success. This guide examines the seven most impactful NLP libraries of 2025, comparing their strengths, limitations, and ideal use cases to help you make an informed decision for your next development project.

1. Hugging Face Transformers 6.0: The Comprehensive Ecosystem

Hugging Face Transformers has cemented its position as the go-to library for accessing state-of-the-art NLP models, and the 6.0 release takes its capabilities to new heights. Far more than just a model repository, Transformers has evolved into a comprehensive ecosystem that covers the entire NLP development lifecycle.

Key Features and Improvements

The latest version introduces several game-changing features:

Efficient Fine-tuning Framework: The new EFT module significantly reduces the computational requirements for adapting foundation models to specific tasks. Models that previously required multiple GPUs for fine-tuning can now be customized on consumer hardware with minimal performance trade-offs.

Multimodal Pipelines: Transformers now offers streamlined pipelines for building applications that seamlessly combine text analysis with image, audio, and even video understanding—perfect for creating more context-aware applications.

Enterprise-Grade Deployment Tools: The new deployment toolkit simplifies moving models from research to production with automated optimization for different hardware targets, from server clusters to mobile devices.

Domain Specialization Packs: Pre-configured settings and models for specific industries like healthcare, legal, and finance allow developers to start with domain-optimized foundations rather than generic models.

Why Developers Love It

Transformers continues to dominate because it strikes an exceptional balance between accessibility and cutting-edge capabilities. The well-documented API makes it straightforward for newcomers to implement advanced NLP features, while the extensive customization options satisfy the needs of experienced ML engineers.

The vibrant community surrounding Hugging Face also means solutions to common problems are usually just a forum search away, significantly reducing development time. With over 75,000 pre-trained models now available in the Model Hub, developers can often find specialized models that closely match their use case requirements without starting from scratch.

Ideal Use Cases

Hugging Face Transformers 6.0 excels for:

Research projects requiring quick experimentation with different model architectures

Production applications needing state-of-the-art language understanding

Teams wanting to leverage community knowledge and resources

Projects requiring specialized domain knowledge (healthcare, legal, finance)

Applications needing multimodal capabilities

Considerations

While Transformers remains the most versatile option, it's not always the most resource-efficient choice for deployment. Some developers report that the generalized architecture introduces overhead that specialized libraries avoid. Additionally, the rapidly evolving codebase means occasional breaking changes between major versions.

2. SpaCy 4.0: Production-Ready Efficiency

SpaCy has long been the workhorse of production NLP systems, and version 4.0 reinforces this position while expanding its capabilities to incorporate transformer-based models more seamlessly than ever. The library's focus on production efficiency combined with state-of-the-art accuracy makes it ideal for systems that need reliability at scale.

Key Features and Improvements

SpaCy 4.0 brings significant enhancements to the table:

Transformer Integration: The updated transformer pipeline components now work natively with the latest models while maintaining SpaCy's efficient processing architecture.

Enhanced Multiprocessing: New parallel processing capabilities provide near-linear scaling for document processing tasks, making SpaCy suitable for batch processing enormous text collections.

Expanded Structured Prediction: Beyond named entity recognition and dependency parsing, SpaCy now offers enhanced support for custom structured prediction tasks through a more flexible annotation and training framework.

Leaner Runtime Requirements: Despite the increased capabilities, core processing pipelines can now run with significantly reduced memory footprints—crucial for deployment in resource-constrained environments.

Improved Rule Engine: The pattern matching system has been completely overhauled, offering more powerful expressions while improving match speed by up to 300%.

Why Developers Choose It

SpaCy continues to be the preferred choice for production systems because it provides industrial-strength performance with a developer-friendly API. The thoughtfully designed object-oriented architecture makes it easy to integrate into larger applications while maintaining consistent performance.

The new "SpaCy Projects" framework has also simplified the packaging and deployment of end-to-end NLP pipelines, allowing teams to standardize their development workflows from experimentation to production.

Ideal Use Cases

SpaCy 4.0 is perfect for:

High-throughput text processing systems

Production environments where reliability and predictability are crucial

Applications requiring industrial-strength named entity recognition and relation extraction

Projects with deployment constraints (memory, processing power)

Teams that need both classical NLP capabilities and modern neural approaches

Considerations

While SpaCy has made great strides in incorporating transformer models, it still doesn't offer the same breadth of cutting-edge research implementations as Hugging Face. Additionally, some developers find its opinionated architecture less flexible for highly customized research applications.

3. Cohere SDK: API-First Language Intelligence

Cohere has emerged as a powerful alternative in the NLP ecosystem with its SDK that focuses on delivering production-ready language intelligence through a streamlined API. Rather than requiring developers to manage model deployment themselves, Cohere provides access to continuously updated, state-of-the-art models via simple API calls.

Key Features and Improvements

The Cohere platform offers several compelling capabilities:

Command and Command-R Models: These models excel at following specific instructions and understanding nuanced requests, making them ideal for building tools that respond precisely to user queries.

Embed Models: The latest generation embedding models create remarkably accurate semantic representations, significantly outperforming previous approaches in retrieval and classification tasks.

Enterprise Customization: For organizations with specific needs, Cohere now offers customization options that adapt their core models to specialized domains without requiring massive training datasets.

Multilingual Support: Robust capabilities across 100+ languages enable global applications without needing separate models for each language.

Responsible AI Controls: Built-in safety filters and bias detection help developers create systems that meet increasingly important ethical standards.

Why Developers Choose It

The Cohere SDK has gained traction primarily because it dramatically lowers the barrier to implementing sophisticated NLP capabilities. Developers without machine learning expertise can add advanced language understanding to applications with minimal code, while still having fine-grained control over the model behavior when needed.

The API-first approach also means teams don't need to worry about infrastructure management or keeping up with the latest research advancements—Cohere handles these aspects, allowing developers to focus on their application logic.

Ideal Use Cases

Cohere SDK is excellent for:

Startups and teams without dedicated ML infrastructure

Applications that need to scale quickly without managing model deployment

Projects requiring enterprise-grade reliability and support

Multi-language applications serving global markets

Use cases where responsible AI practices are a priority

Considerations

The primary tradeoff with Cohere is that developers are depending on a third-party service rather than running models in their own infrastructure. This creates potential concerns around data privacy, service availability, and long-term pricing stability. Some developers also note that the API-based approach, while convenient, sometimes limits flexibility compared to having direct access to model internals.

4. PyTorch NLP (torchtext 3.0): The Researcher's Choice

For researchers and developers who prefer working closer to the metal, PyTorch's ecosystem continues to offer unparalleled flexibility. The overhauled torchtext 3.0 has evolved from a collection of utilities into a comprehensive NLP framework while maintaining the flexibility that PyTorch users value.

Key Features and Improvements

The latest version brings several significant upgrades:

Native Support for Transformer Architectures: First-class implementations of attention mechanisms and transformer blocks make it easier to implement custom architectures.

Optimized Data Processing Pipelines: New vectorized text processing operations leverage modern CPUs and GPUs more effectively, dramatically speeding up preprocessing steps.

Enhanced Transfer Learning Framework: The refined API makes it straightforward to adapt pre-trained models to new tasks while maintaining precise control over the training process.

Quantization and Pruning Tools: Built-in capabilities for model compression enable researchers to reduce model size and inference time without excessive performance degradation.

Improved Batch Processing: Smarter batching strategies for variable-length sequences result in more efficient GPU utilization during training.

Why Researchers and Developers Choose It

PyTorch NLP remains the preferred choice for research and specialized applications because it offers maximum flexibility without sacrificing usability. The imperative programming style aligns with how most developers think, making it easier to debug models and experiment with novel approaches.

The seamless integration with the broader PyTorch ecosystem also means that advancements in general deep learning (like optimization techniques or training methods) are immediately applicable to NLP tasks.

Ideal Use Cases

PyTorch NLP is best suited for:

Research projects exploring novel architectures or training approaches

Applications requiring customized model behavior not available in higher-level libraries

Educational contexts where understanding model internals is important

Projects where integration with computer vision or other modalities is needed

Situations requiring maximal control over the training process

Considerations

The flexibility of PyTorch NLP comes with a steeper learning curve and more implementation responsibility. Developers need to make more architectural decisions and implement more components from scratch compared to higher-level libraries. Additionally, some production optimization features require additional work to implement properly.

5. JAX NLP (FLAX/Prax): Performance at Scale

JAX has established itself as the framework of choice for training and deploying extremely large language models, and its NLP ecosystem has matured significantly. The FLAX and Prax libraries built on JAX offer unprecedented performance for large-scale NLP workloads while maintaining a reasonable developer experience.

Key Features and Improvements

JAX's NLP ecosystem offers several distinctive advantages:

Transparent XLA Compilation: Automatic optimization for TPUs, GPUs, and specialized hardware delivers remarkable training and inference speed improvements.

Functional Programming Model: The pure functional approach simplifies distribution across multiple devices and helps avoid subtle training bugs.

Advanced Parallelism: Built-in support for model, data, and pipeline parallelism makes training massive models more accessible.

Hardware-Specific Optimizations: Specialized implementations take full advantage of the latest accelerator features from different hardware vendors.

Differential Privacy Integration: Built-in support for private training methods addresses growing regulatory requirements around data privacy.

Why Teams Choose It

Organizations working with extremely large models or datasets choose JAX-based solutions primarily for the performance benefits. Models that would take weeks to train on other frameworks can often be completed in days with JAX, representing significant cost savings in cloud compute resources.

The functional approach also brings benefits for reproducibility and debugging, which become increasingly important as models grow in complexity and training runs become more expensive.

Ideal Use Cases

JAX NLP is ideal for:

Training and deploying very large language models

Organizations with access to specialized hardware (TPUs, etc.)

Projects requiring maximum computational efficiency

Situations where reproducibility is critical

Applications demanding rigorous privacy guarantees

Considerations

JAX's programming model, while powerful, represents a significant departure from the more familiar object-oriented approaches of other frameworks. This can increase the initial learning curve, particularly for developers without a strong functional programming background. Additionally, while the ecosystem is growing rapidly, it still has fewer ready-to-use components than more established frameworks.

6. TensorFlow Text 3.0: stabilność przedsiębiorstwa

Kluczowe funkcje i ulepszenia

TensorFlow Text 3.0 oferuje kilka ważnych udoskonaleń:

Integracja z TF Extended: Bezproblemowe połączenie z narzędziami produkcyjnymi ML TensorFlow upraszcza podróż od eksperymentów do wdrożenia.

Ulepszona obsługa TFLite: Ulepszone operacje przetwarzania tekstu w TFLite sprawiają, że wdrażanie modeli NLP na urządzeniach mobilnych i brzegowych jest bardziej praktyczne.

Spójne doświadczenie międzyplatformowe: Te same modele i potoki przetwarzania działają niezawodnie w środowiskach szkoleniowych i wnioskowania, od chmurowych TPU po urządzenia mobilne.

Rozszerzona integracja korporacyjna: Natywne łączniki dla typowych źródeł danych korporacyjnych upraszczają włączanie przetwarzania tekstu do istniejących przepływów pracy.

Kompleksowe opcje obsługi: od obsługi TF do SavedModel i TFLite, opcje wdrażania obejmują praktycznie każde środowisko docelowe.

Dlaczego organizacje je wybierają

TensorFlow Text pozostaje popularny w środowiskach korporacyjnych, ponieważ oferuje kompletne rozwiązanie od przygotowania danych do wdrożenia. Stabilność interfejsu API i rozbudowane opcje wdrażania zmniejszają ryzyko związane z włączaniem przetwarzania języka naturalnego do aplikacji o znaczeniu krytycznym.

Integracja z ofertą chmury Google zapewnia również prostą ścieżkę skalowania dla organizacji, które już zainwestowały w ten ekosystem.

Idealne przypadki użycia

TensorFlow Text 3.0 sprawdza się w:

Aplikacjach korporacyjnych wymagających stabilności produkcji

Scenariuszach wdrażania mobilnego i brzegowego

Organizacjach z istniejącymi inwestycjami w TensorFlow

Projektach wymagających kompleksowych potoków ML

Aplikacji, w których elastyczność wdrażania jest niezbędna

Rozważania

Podczas gdy TensorFlow Text nadal dodaje nowe możliwości, czasami pozostaje w tyle za innymi strukturami we wdrażaniu najnowszych osiągnięć badawczych. Dodatkowo niektórzy programiści uważają, że model programowania symbolicznego jest mniej intuicyjny w eksperymentach niż imperatywne podejście PyTorch.

7. Flair 2.0: NLP, czyli szwajcarski scyzoryk

Kluczowe funkcje i ulepszenia

Flair 2.0 wprowadza kilka znaczących ulepszeń:

Hybrid Embeddings Framework: Łatwe łączenie różnych typów osadzeń (kontekstowych, statycznych, na poziomie znaków) w celu uzyskania optymalnej wydajności dla określonych zadań.

Możliwości uczenia się na jednym podejściu: Nowe techniki uczenia się na kilku podejściach zapewniają zaskakująco dobre wyniki w przypadku specjalistycznych zadań przy minimalnej ilości danych oznaczonych.

Ulepszona inteligencja dokumentów: Ulepszone podejścia do modelowania dokumentów lepiej wychwytują zależności dalekiego zasięgu w długich tekstach.

Usprawnione dostrajanie: Uproszczone przepływy pracy w celu dostosowania wstępnie wyszkolonych modeli do określonych domen lub zadań.

Mniejsze wymagania dotyczące zasobów: Zwiększona wydajność sprawia, że Flair nadaje się do wdrożenia na mniej wydajnym sprzęcie.

Dlaczego programiści go wybierają

Flair zyskał oddanych zwolenników, ponieważ zapewnia doskonałą równowagę między mocą a prostotą. Biblioteka oferuje niemal najnowocześniejszą wydajność dla wielu typowych zadań NLP, wymagając jednocześnie znacznie mniej kodu i zasobów obliczeniowych niż cięższe frameworki.

Intuicyjny projekt interfejsu API sprawia, że jest on dostępny również dla programistów, którzy nie są specjalistami NLP, umożliwiając im włączenie zaawansowanego rozumienia języka do swoich aplikacji przy stosunkowo łagodnej krzywej uczenia się.

Idealne przypadki użycia

Flair 2.0 sprawdza się najlepiej w przypadku:

Projektów wymagających doskonałego etykietowania sekwencji (oznaczanie NER, POS)

Aplikacji o ograniczonych zasobach obliczeniowych

Zespołów poszukujących szybkiej implementacji standardowych zadań NLP

Scenariuszy z minimalnymi danymi treningowymi z etykietami

Specjalistycznych aplikacji klasyfikacji tekstu

Rozważania

Podczas gdy Flair nadal rozszerza swoje możliwości, nie oferuje on tej samej szerokości modeli i technik, co większe frameworki, takie jak Hugging Face Transformers. Dodatkowo niektórzy programiści zauważają, że dokumentacja, choć ulega poprawie, nadal nie zawiera kompleksowych przykładów, które można znaleźć w bardziej popularnych bibliotekach.

Wnioski: Wybór odpowiedniej biblioteki NLP dla Twoich potrzeb

Hugging Face Transformers 6.0 zapewnia najbardziej kompleksowy wybór ekosystemu i modeli

SpaCy 4.0 zapewnia wydajność przemysłową i niezawodność produkcji

Cohere SDK oferuje wygodę API-first dzięki stale aktualizowanym modelom

PyTorch NLP zapewnia badaczom maksymalną elastyczność i kontrolę

JAX NLP zapewnia niezrównaną wydajność dla aplikacji na dużą skalę

TensorFlow Text 3.0 zapewnia stabilność przedsiębiorstwa i opcje wdrażania

Flair 2.0 łączy imponujące możliwości w lekkim pakiecie

Właściwy wybór zależy od Twoich konkretnych wymagań:

Jeśli chodzi o szybkie prototypowanie i dostęp do najnowocześniejszych modeli, Hugging Face Transformers pozostaje trudny do pobicia. Jeśli niezawodność i wydajność produkcji są Twoimi głównymi obawami, SpaCy nadal góruje. Gdy najważniejsze są szybkość rozwoju i łatwość implementacji, podejście Cohere API-first oferuje przekonujące zalety.

Badacze wymagający maksymalnej elastyczności nadal będą skłaniać się ku PyTorch NLP, podczas gdy organizacje szkolące masywne modele skorzystają z optymalizacji wydajności JAX. Przedsiębiorstwa ceniące stabilność i kompleksowe opcje wdrażania uważają TensorFlow Text za bezpieczny wybór, a zespoły poszukujące lekkiego rozwiązania o imponujących możliwościach powinny rozważyć Flair.

W miarę jak technologia NLP nadal rozwija się w niezwykłym tempie, pozostawanie na bieżąco z możliwościami tych bibliotek i trendami rozwojowymi pomoże Ci dokonać najlepszego wyboru dla Twoich projektów i utrzymać Twoje aplikacje na czele.

Jaki jest Twój następny projekt NLP i która z tych bibliotek może idealnie pasować do Twoich konkretnych wymagań?